深度学习(大数据人工智能)运行或训练时对CPU的要求高吗

文 / @WordPress主题

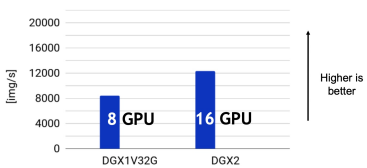

虽然CPU的参与方式与深度学习模型计算无关,但其在数据处理方面扮演了一个极为关键的角色。想象一下,一台拥有8块NVIDIA V100 GPU的DGX服务器,它可以每秒处理高达8000张ImageNet图像的ResNet-50图像分类任务,但当我们升级到拥有16块V100 GPU的DGX2服务器时,吞吐量并没有如我们所预期的那样翻倍。这个现象暗示着DGX2服务器的CPU已经成为性能的限制因素。

通常,我们会为每块GPU分配一定数量的CPU逻辑核心。在理想情况下,模型计算吞吐量应该随着GPU数量的增加而线性增长,因此,单个GPU的合理CPU逻辑核心数分配可以直接扩展到多个GPU。对于每块GPU,至少需要分配4到8个核心的CPU,以满足多线程的异步数据读取需求。然而,增加更多的核心通常不会带来显著的性能提升,因为此时的数据读取瓶颈通常源于Python的多进程切换和数据通信开销(例如,使用PyTorch DataLoader)。那么,如何在保持成本控制的同时克服数据读取瓶颈呢?或许您可以在AutoDL平台上尝试一下NVIDIA DALI数据读取加速库,这个库是使用C++和CUDA编写的。根据我们的测试结果,使用单核CPU实例进行数据读取的性能超越了使用基于Python的八核心实例,这无疑为模型训练提供了强大的支持。

相关文章

-

深度学习常见gpu硬件选购指南 2023-10-10 00:37:12

-

专业的网站建设与SEO(搜索引擎优化)服务商——西安优思慕 2023-10-07 14:56:01

-

从SRE是什么开始,一文让你了解SRE运维工程师这个岗位 2023-10-03 15:19:44

-

苹果iOS17正式发布,续航信号大幅改善,神话级性能优化 2023-09-20 14:25:47

-

WordPress站点的cookie如何设置httpOnly标志位 2023-09-19 15:54:37

-

FPGA是什么?用什么语言编程?FPGA工程师前景如何? 2023-09-18 21:50:21

-

广播IP地址是什么意思(含:广播ip和原生ip区别) 2023-09-15 12:02:06

-

西安雁塔未来人工智能计算中心如何注册账户 2023-09-14 18:22:52

-

西安雁塔未来人工智能计算中心介绍(含:项目地址与官网地址) 2023-09-14 18:03:12

-

一文让你完全了解PCIE接口 2023-08-15 09:50:05